La realidad realidad virtual, cada vez está más cerca de instalarse en nuestro día a día.

Sin embargo, aún es una tecnología desconocida para muchos, y el papel de la música y el sonido en este tipo de experiencias son claves.

«Existe una dominancia visual, nos regimos por lo que vemos, y por eso se da prioridad a ese sentido en la realidad virtual», explica Jean-Luc Cohen, profesor del Berklee College of Music en Boston y Nueva York y experto en realidad virtual. «El tema de la música y del audio en la realidad virtual (VR) ha quedado en un segundo plano. Lo visual es siempre lo que rige, pero las compañías están viendo que esto es mucho más potente cuando el audio complenta lo visual», añade Pablo Munguía, ingeniero de sonido de las ceremonias de los Óscar y Grammys.

Ambos expertos estuvieron en Madrid hace unos días, reivindicando el papel de la música en la realidad virtual, en la cuarta conferencia The XR Date en la Fundación Telefónica. «Hay cuatro áreas clave en estas experiencias: la riqueza del ambiente, lo visual, el audio y la narrativa. Hasta ahora se ha puesto mucho el foco en la riqueza de lo visual, pero la realidad es que la mejor experiencia se logra cuando consigues un balance entre los cuatro elementos. Si te enfocas en lo visual y descuidas lo demás, la experiencia va a ser más pobre y va a ser más difícil conseguir la inmersión», explica Munguía.

Ese elemento, la inmersión, es precisamente la clave del éxito para Jean-Luc Cohen, quien explica que este «no es un concepto nuevo sino que ahora tenemos nuevas y mejores herramientas para desarrollarlo». Según explica el francés, un libro, una película o un videojuego (incluso uno antiguo) pueden lograr una gran inmersión mediante la narrativa. «El sonido es también una de las mejores herramientas para crear inmesiones» y para romperlas, cuando se usa mal y choca con lo visual, que es lo que manda. Ahora, la realidad virtual añade otros dos potentes efectos de inmersión: la presencia espacial, «la sensación de estar en un lugar en el que no estamos físicamente», y la capacidad de interactuar con ese entorno.

Sin embargo, para que el efecto funcione a la perfección no hay que descuidar los otros elementos: la narrativa, la música y la coherencia de lo que se muestra.

Para Munguía, la música en entornos de realidad extendida signfica mucho más, él ve ahí «el futuro de la industria de la música». El ingeniero habla de tres periodos en la historia del consumo musical: el preestático, donde la única forma de escucharla era con músicos en vivo y una pieza nunca era dos veces igual; el estático, el que la música está grabada y los oyentes tienen la expectativa de escucharla tal cual suena en el disco o el formato que sea (lo que influye incluso en cómo los artistas interpretan la música en directo); y el posestático, que es hacia el que vamos con la VR. «Son estructuras no lineales que nos permiten tener una experiencia con la que podemos interactuar», detalla. Afirma que el gran beneficio es que «son experiencias difícilmente pirateables» y eso puede tener «un impacto muy positivo en la industria de la música, que sobrevive en un modelo que ahora no es viable. «Ahora dominan lo que yo llamo la segunda ola de los piratas, que está personalizada por sistemas de streaming como Spotify, Apple Music, Pandora…

Están haciendo esencialmente lo mismo que hacía Napster, tomar el contenido que crean los músicos y usarlo como mejor les parece, cobrar lo que ellos quieren pagar sin apenas una negociación. Esto es lo que hace un pirata», sentencia. «El modelo hoy por hoy no es un modelo viable. Las discográficas han entrado en estas negociaciones y han creado un ambiente en el que simplemente va a ser imposible que las compañías de streaming vayan a tener un éxito comercial, sin embargo en este momento es la única salida», concluye, con su esperanza puesta en la realidad extendida para cambiar la realidad de la industria.

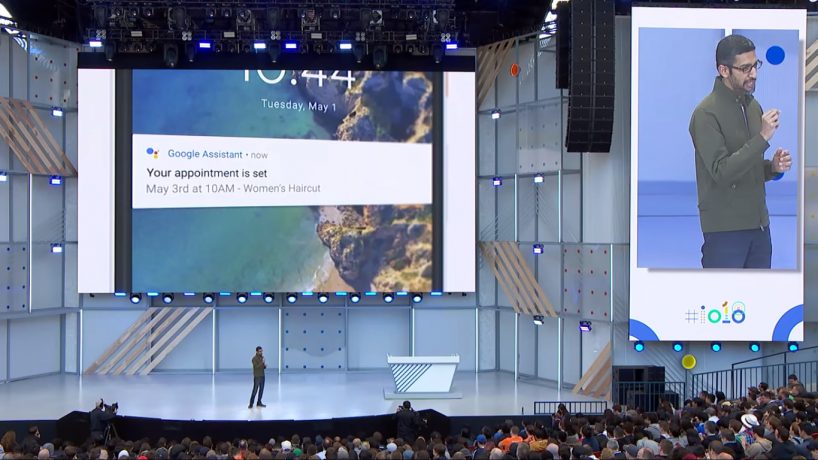

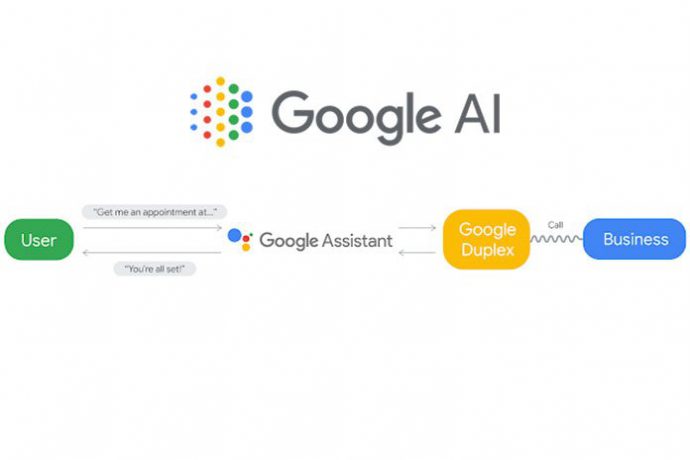

Nuevo diseño para Gmail Mediante la Smart Compose (composición o redacción inteligente), la nueva versión de Gmail está programada para ser de ayuda a los usuarios de cara a la redacción de correos electrónicos y a predecir lo que quieren escribir basándose en el contexto. Gmail es una herramienta usada por millones de usuarios en el mundo y para varios asuntos, lo cual permitirá que la compañía pueda mejorar esta herramienta predicitiva de manera progresiva. Smart Compose llegará a los usuarios durante las próximas semanas, siempre que tengan el nuevo diseño de Gmail. Aún se desconoce si dicho mecanismo se trasladará para su funcionamiento en otros idiomas que no sean el inglés.

Nuevo diseño para Gmail Mediante la Smart Compose (composición o redacción inteligente), la nueva versión de Gmail está programada para ser de ayuda a los usuarios de cara a la redacción de correos electrónicos y a predecir lo que quieren escribir basándose en el contexto. Gmail es una herramienta usada por millones de usuarios en el mundo y para varios asuntos, lo cual permitirá que la compañía pueda mejorar esta herramienta predicitiva de manera progresiva. Smart Compose llegará a los usuarios durante las próximas semanas, siempre que tengan el nuevo diseño de Gmail. Aún se desconoce si dicho mecanismo se trasladará para su funcionamiento en otros idiomas que no sean el inglés.